Meta 推出了Llama 3介绍视频,有几个细节值得分享给大家

![图片[1]-Meta宣布Llama 3细节:真正关键的模型后训练阶段-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0425%2Fa63ca038j00sch0ii008ld200u000eqg00it0098.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

Llama 3模型本体

Llama 3 训练数据(15万亿token)是Llama 2的7倍,微调数据(1000条万人类标注)是Llama 2的10倍

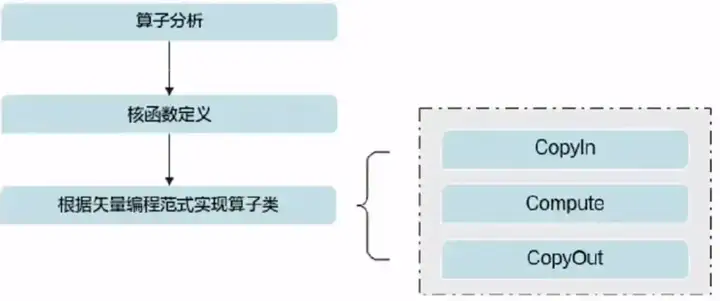

Llama 3开发思路:四个顶层设计

1. 使用密集自回归Transformer模型架构,除了群组查询注意力机制外还添加了新的分词器 2. 两个自定义的24k H100 超级训练集群用于训练 3. 真正的关键是后训练阶段:生成了大量人工注释,执行了大量SFT(监督微调) 4. 关注实用性:回答问题能力,事实上的准确性等

Llama 3 其他亮点

开发人员设计了一个从头支持Llama 3的纯粹的PyTorch 微调库torchtune,没有依懒项,已经与HuggingFace 和其他一些库进行了集成

Llama 3 未来计划

4000 亿参数,支持多种语言 Llama 3 400B还在训练,它是实现Meta多模态AI的关键

© 版权声明

THE END