4月19日,Facebook母公司Meta重磅推出了Llama3。

即便大家现在对于大厂和巨头频繁迭代AI模型的行为已经见怪不怪,Meta的Llama3仍旧显得与众不同,因为这是迄今最强大的开源AI模型。

Meta推出了重磅级产品Llama,显然是剑有所指的,其中的寓意也很明显,即是要在激烈的行业竞争中追赶领先者OpenAI。由此,我们也能看出Mata在AI领域的雄心壮志。

![图片[1]-Llama3,凭什么价值百亿美金?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0422%2F9153fee0j00scc2u7005id001400140m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

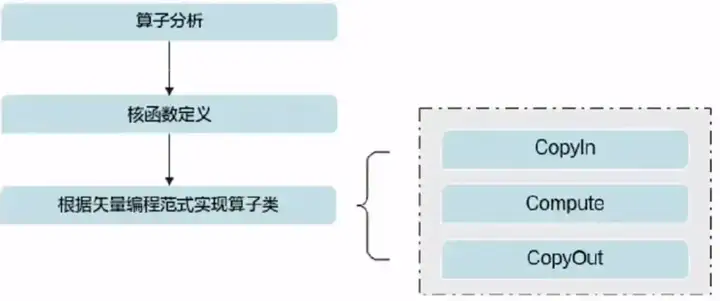

成为最强开源模型,Llama3究竟是怎样炼成的?

之所以说Llama3是“最强开源”,是因为它在模型架构,预训练数据,扩大预训练规模以及指令微调方面都做出了重要的调教。

![图片[2]-Llama3,凭什么价值百亿美金?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0422%2F930d9e7fj00scc2u80048d001z10140m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

在模型架构方面,Llama 3 采用了相对标准的纯解码器 transformer 架构。与 Llama 2 相比,Llama 3更进行了几项关键改进。Llama 3 使用了一个 128K token 的 tokenizer,它能更有效地编码语言,从而大幅提高模型性能;Meta还在 8B 和 70B 大小的模型中都采用了分组查询关注,以便提高Llama3的运行效率;此外,Meta还在8192 个 token 的序列上对模型进行了训练,并使用掩码来确保自注意力不会跨越文档边界。

训练数据方面,Meta 表示,要训练出最佳的语言模型,最重要的是策划一个大型且高质量的训练数据集。根据数据现实,Llama 3 在超过 15T 的 token 上进行了预训练,训练数据集是 Llama 2 的7倍,包含的代码数量达到了Llama 2 的4倍。为了应对多语言使用情况,Llama 3 的预训练数据集中有超过5%的部分是高质量的非英语数据,涵盖 30 多种语言。而为了确保Llama 3始终在最高质量的数据上进行训练,Meta还开发了一系列数据过滤管道,诸如启发式过滤器,NSFW 过滤器,语义重复数据删除方法,文本分类器等,以便更好的预测数据质量。与此同时,Meta还进行了大量实验,确保 Llama 3 在各种使用情况下都能表现出色,包括琐事问题,STEM,编码,历史知识等。

在扩大预训练规模方面,为了让Llama 3 模型有效利用预训练数据,Meta 为下游基准评估制定了一系列详细的 scaling laws。这些 scaling laws 使他们能够选择最佳的数据组合,并就如何更好地使用训练计算做出最佳决定。更重要的是,在实际训练模型之前,scaling laws允许他们预测最大模型在关键任务上的性能,这有助于 Llama 3 在各种用例和功能中都能发挥强大的性能。

在指令微调方面,为了在聊天用例中充分释放预训练模型的潜力,Meta 对指令微调方法进行了创新,在后期训练方法中结合了监督微调(SFT),拒绝采样,近似策略优化(PPO)以及直接策略优化(DPO)。

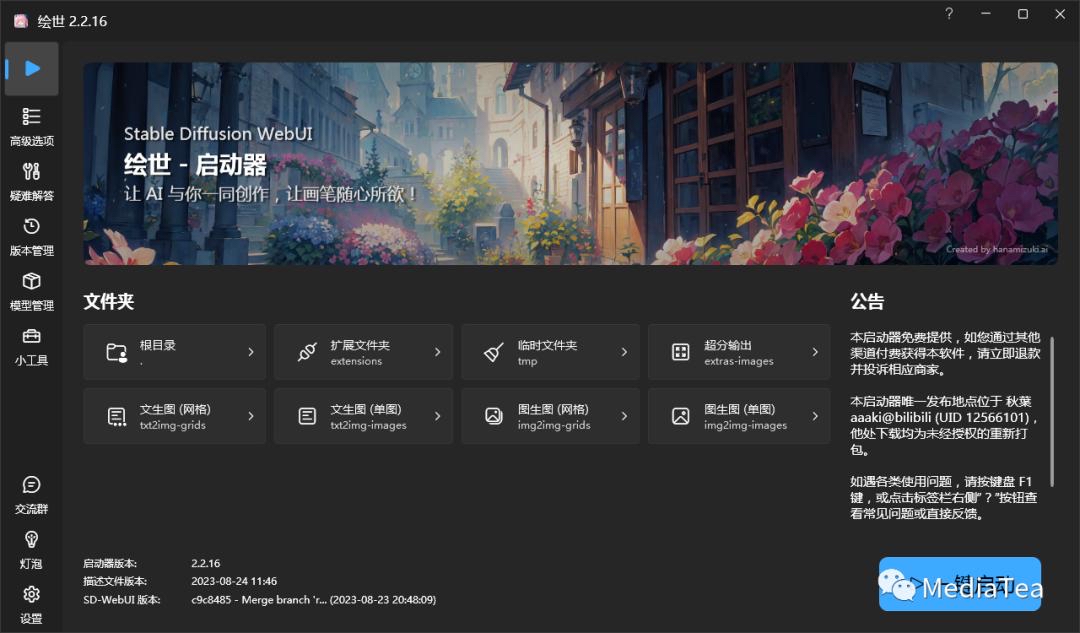

官方表示即将推出400B+版本…开源的400B+足够令人期待。

此次Llama3的发布,还有一点惹人瞩目,那就是Meta官方表示,即将在不久的未来推出400B+版本。

Meta 官方表示,Llama 3 8B 和 70B 模型只是 Llama 3 系列模型的一部分,他们后续还将推出更多版本,其中就包括模型参数超过 400B 的 Llama 3 版本,这一版本目前仍在训练中。

![图片[3]-Llama3,凭什么价值百亿美金?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0422%2F850d62d0j00scc2ua003ed001o00140m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

在接下来的几个月中,Meta会持续推出新功能:届时会有更多的模态;更长的上下文窗口;更多不同大小版本的模型;更强的性能等。关于Llama 3研究论文也一应推出。

另外,Llama 3 模型将很快会在AWS,Databricks,Google Cloud,Hugging Face,Kaggle,IBM WatsonX,Microsoft Azure,NVIDIA NIM 以及Snowflake 上提供,并得到 AMD,AWS,Dell,Intel,NVIDIA 以及Qualcomm 硬件平台的支持。

当然,大家最期待的,还是即将推出的,参数超过400B+的版本。目前Llama3模型的最强参数是70B。这个数据已经十分优秀了,完全有能力和GPT-4-Turbo,Mistral-Large,Claude3-Opus相媲美。不过,相较于巨头的最强模型,仍旧存在不小的差距。这也是大家如此期待400B+版本的重要原因。

![图片[4]-Llama3,凭什么价值百亿美金?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0422%2F2b1f7b76j00scc2ub0031d001z10140m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

400B+的版本仍在训练中,单就目前释放出的评测结果来看已经非常强了,堪称Llama开源size中的“超大杯选手”。据悉,该模型的训练成本会达到1亿美元。目前我们还不清楚Meta是否会开源“超大杯”。一旦开源,对于国内的大模型公司来说无疑是个重大利好。相信在此之后,也会有很多公司争先跟上,推出后续的应用。但凡事都有两面,对于OpenAI,Anthropic,Mistral,Google这些巨头而言,这未必是个好消息。

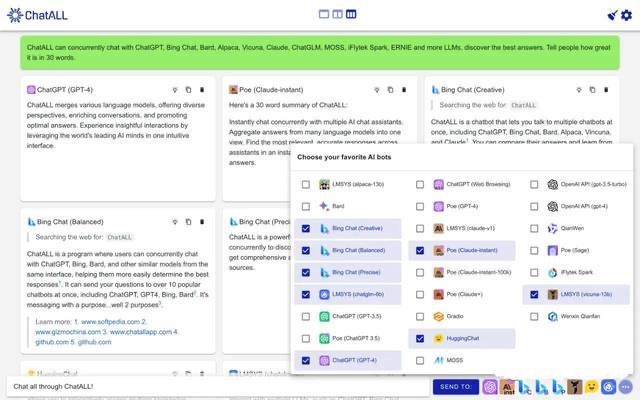

“开源大模型”时代以来,AI会越来越失控吗?

AI大模型如雨后春笋般不断冒出,大家在见识到AI愈发强大,愈发智能的同时,也会感知到危机感。

![图片[5]-Llama3,凭什么价值百亿美金?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0422%2F0b30bb72j00scc2ud004ad001z10140m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

AI是否会变得越来越失控?

对此,Meta CEO 马可.扎克伯格也在最近接受的访谈中表达了自己的观点。他认为,AI的定位应该在于“一项非常基础性的技术”。它的存在应该像计算机一样,将催生一系列全新的应用。人们之所以会诞生AI会失控,很大程度上是因为它发展的速度太快了,一时之间我们无法适应。

但在扎克伯格看来,这种情况不太可能发生,因为这其中存在很多物理方面的限制。但有一点毋庸置疑:AI将真正改变我们的工作方式,为人们提供创新的工具去做不同的事情。它将使人们能够更自由地追求他们真正想做的事情。

![图片[6]-Llama3,凭什么价值百亿美金?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0422%2F1b00e4a5j00scc2uf004hd001nl0140m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

事实上,我们无法预知AI未来的发展路径究竟是怎样的,是会真的造福人类,还是会给人类带来灾难。但有一点值得肯定:开源的AI系统确实有助于建立一个更公平,更平衡竞技场。如果开源的机制可以运作成功,那应该会成为大家所期待的未来。